可微神經(jīng)網(wǎng)絡(luò)模塊組裝

中文題目:可微神經(jīng)網(wǎng)絡(luò)模塊組裝

論文題目:Differentiable Neural Network for Assembling Blocks

錄用期刊/會議:The 27th European Conference on Artificial Intelligence ECAI 2024 (CCF-B類會議)

原文DOI:10.3233/FAIA240747

原文鏈接:https://doi.org/10.3233/FAIA240747

錄用/見刊時間:2024.10

作者列表:

1)劉志偉 中國石油大學(xué)(北京)人工智能學(xué)院 計算機科學(xué)與技術(shù) 碩21

2)魯 強 中國石油大學(xué)(北京)人工智能學(xué)院 智能科學(xué)與技術(shù)系副教授

3)趙藝博 中國石油大學(xué)(北京)人工智能學(xué)院 計算機科學(xué)與技術(shù) 碩23

4)趙艷紅 昆侖數(shù)智科技有限責(zé)任公司 北京

5)Jake Luo University of Wisconsin Milwaukee Department of Health Informatics and Administration Associate Professor

摘要:

模塊組裝的目標(biāo)是針對不同數(shù)據(jù)集從預(yù)訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型中選擇模塊,組合成一個新的神經(jīng)網(wǎng)絡(luò)。通過重用這些模塊的權(quán)重,使得訓(xùn)練變得高效。本文提出一種稱為PA-DNN的端到端可微神經(jīng)網(wǎng)絡(luò)。PA-DNN由劃分神經(jīng)網(wǎng)絡(luò)模塊和組裝神經(jīng)網(wǎng)絡(luò)模塊組成。其中劃分神經(jīng)網(wǎng)絡(luò)模塊將根據(jù)新數(shù)據(jù)集把現(xiàn)有的預(yù)訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型劃分成模塊;組裝神經(jīng)網(wǎng)絡(luò)模塊選擇這些模塊中的一部分,并使用縫合層將它們組合成新的神經(jīng)網(wǎng)絡(luò)。實驗結(jié)果表明,與手工設(shè)計的網(wǎng)絡(luò)、神經(jīng)結(jié)構(gòu)搜索方法和神經(jīng)網(wǎng)絡(luò)組裝方法DeRy相比,PA-DNN能夠以更低的訓(xùn)練代價生成更精確、更輕量級的神經(jīng)網(wǎng)絡(luò)。

背景與動機:

目前已經(jīng)積累了大量的神經(jīng)網(wǎng)絡(luò),如HuggingFace和MMPretrain中提供了大量在特定數(shù)據(jù)集上訓(xùn)練好的模型。雖然這些預(yù)先訓(xùn)練的神經(jīng)網(wǎng)絡(luò)模型在原始訓(xùn)練數(shù)據(jù)集上表現(xiàn)較好,但當(dāng)遇到新的數(shù)據(jù)集時,它們的性能可能會下降,通常需要手動調(diào)整模型結(jié)構(gòu)或重新訓(xùn)練以適配新的數(shù)據(jù)集,這會耗費大量人力和計算資源。為緩解此問題,本文提出PA-DNN模型最大化重用模型權(quán)重,可以有效減少訓(xùn)練成本。

設(shè)計與實現(xiàn):

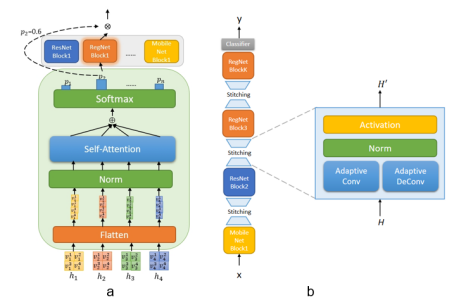

劃分組裝可微神經(jīng)網(wǎng)絡(luò)(PA-DNN)總體框架如圖1所示。首先,從類似于 Huggingface 的預(yù)訓(xùn)練模型庫中選擇一些模型作為模型庫。基于新數(shù)據(jù)集,利用劃分神經(jīng)網(wǎng)絡(luò)模塊學(xué)習(xí)劃分點的概率分布,將預(yù)訓(xùn)練的模型拆分為模塊。在獲得劃分好的模型庫后,組裝神經(jīng)網(wǎng)絡(luò)模塊將通過路由模塊(如圖2a)來選擇其中的一些模塊,并使用縫合層(如圖2b)將模塊連接得到組裝模型。訓(xùn)練時利用驗證數(shù)據(jù)集更新路由模塊的參數(shù),以指導(dǎo)結(jié)構(gòu)生成;利用訓(xùn)練數(shù)據(jù)集更新縫合層參數(shù),以適配目標(biāo)任務(wù)。然而,獲取組裝模型的精度需要多次的前向傳播和梯度下降迭代,非常耗時。為了克服這個問題,使用評分函數(shù)預(yù)測組裝模型的精度,無需在評估期間重新訓(xùn)練組合出的神經(jīng)網(wǎng)絡(luò)。訓(xùn)練后,PA-DNN 會微調(diào)最佳模型的縫合層以適配新的數(shù)據(jù)集。PA-DNN以端到端的方式完成了網(wǎng)絡(luò)劃分與模塊組裝。

圖1 劃分組裝可微神經(jīng)網(wǎng)絡(luò)模型(PA-DNN)

圖2 路由模塊和縫合層

實驗結(jié)果及分析:

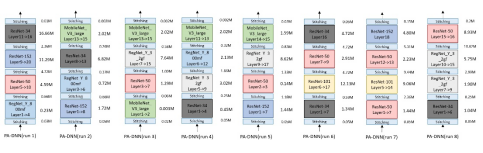

在CIFAR-10和CIFAR-100數(shù)據(jù)集上分別運行PA-DNN四次得到的模型結(jié)構(gòu)圖,其中相同色塊表示來源于相同的預(yù)訓(xùn)練模型(如圖3所示)。

圖3模型結(jié)構(gòu)圖

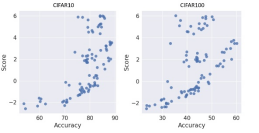

為驗證所提出的評分函數(shù),在NAS-Bench-201數(shù)據(jù)集上進行實驗。如圖4所示,性能評估得分和模型準(zhǔn)確率整體上呈線性正相關(guān)。

圖4 評分函數(shù)與模型精度關(guān)系圖

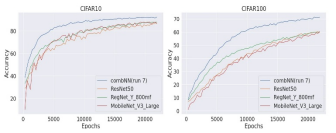

圖5 驗證準(zhǔn)確率對比結(jié)果

圖6 準(zhǔn)確率和訓(xùn)練參數(shù)對比結(jié)果

結(jié)論:

本文提出了一種新的神經(jīng)網(wǎng)絡(luò)模塊組裝方法——劃分組裝可微神經(jīng)網(wǎng)絡(luò)(PA-DNN)。該方法使用端到端的可微分神經(jīng)網(wǎng)絡(luò)來從神經(jīng)網(wǎng)絡(luò)模型庫中組裝神經(jīng)網(wǎng)絡(luò)模塊。PA-DNN主要由兩個部分組成:劃分神經(jīng)網(wǎng)絡(luò)模塊和組裝神經(jīng)網(wǎng)絡(luò)模塊,分別負(fù)責(zé)模型劃分和網(wǎng)絡(luò)組裝。與手工設(shè)計的模型、神經(jīng)結(jié)構(gòu)搜索方法和DeRy方法相比,PA-DNN以較小的搜索成本組裝出新的網(wǎng)絡(luò),并以較小的訓(xùn)練成本就可以得到較好的模型表現(xiàn)。

通訊作者簡介:

魯強:副教授,博士生導(dǎo)師。目前主要從事演化計算和符號回歸、知識圖譜與智能問答、以及軌跡分析與挖掘等方面的研究工作。

聯(lián)系方式:luqiang@cup.edu.cn